Imaginez le bazar si quelqu’un ajoutait par erreur tous les Jean-Michel de votre entreprise dans une conversation de groupe ! C’est un peu ce qui est arrivé chez Microsoft cette semaine. De nombreux employés prénommés Mike ou Michael ont eu la surprise de se retrouver sans le vouloir dans une boucle d’échanges par mail.

Michael Schechter, le VP de Bing, raconte s’être réveillé avec une quantité inhabituelle d’emails non lus. Sur le coup, il a cru à un gros plantage en prod pendant la nuit, mais non, en fait c’est juste une personne qui s’est amusée à créer un groupe avec beaucoup de gens qui s’appellent Mike ou Michael chez Microsoft. Et pas de bol pour eux, ils sont nombreux !

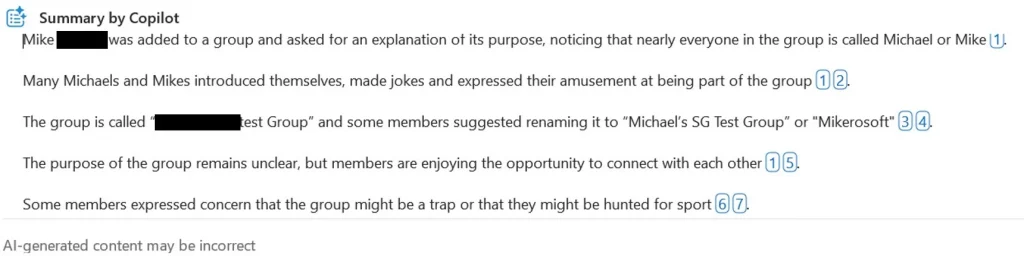

Face à cette situation ubuesque, Michael a eu le réflexe de demander à Copilot (l’assistant d’IA de krosoft) de résumer le fil de discussion et croyez-moi, ça vaut son pesant de cacahuètes ! D’après Copilot, les participants ont commencé par demander des explications sur le but de ce groupe, tout en notant avec amusement qu’ils avaient le même prénom. Évidemment, ça n’a pas manqué de partir en vrille et chacun y est allé de sa petite blague, de jeux de mots rigolos comme renommer le groupe en « Mikerosoft« . Certains se sont même demandé avec humour si ce n’était pas un piège pour les virer !

Le plus drôle dans l’histoire, c’est que malgré les nombreux messages, personne n’a compris qui avait créé ce groupe ni pourquoi. Un beau mystère ! En attendant, les participants en ont profité pour faire connaissance. Si ça se trouve, il y en a même qui en ont profité pour corriger des bugs… roooh.

Ça rappelle quand même qu’il faut toujours faire attention avec les emails de groupe ou les mises en copie. Une erreur est vite arrivée et on a vite fait d’envoyer des conneries et de les regretter après ! Une histoire similaire a d’ailleurs eu lieu dans les années 90 selon Eric Lippert. Un type voulait contacter « Mike de Microsoft » qu’il avait rencontré à une conf sauf qu’il a réussi à chopper les adresses des 600 Mike de la boîte. La presse avait titré à l’époque « Heureusement qu’ils ne cherchaient pas Bill » !

L’histoire ne dit pas s’il vont s’organiser un barbecue ou séminaire entre Mike, mais je troue que « Mikerosoft », ça sonne quand même mieux que Microsoft, non ?