LLocalSearch - Le moteur de recherche local basé sur des agents IA

LLocalSearch est un moteur de recherche qui fonctionne entièrement en local sur votre machine, qui utilise des agents IA pour effectuer des recherches directement sur votre ordinateur.

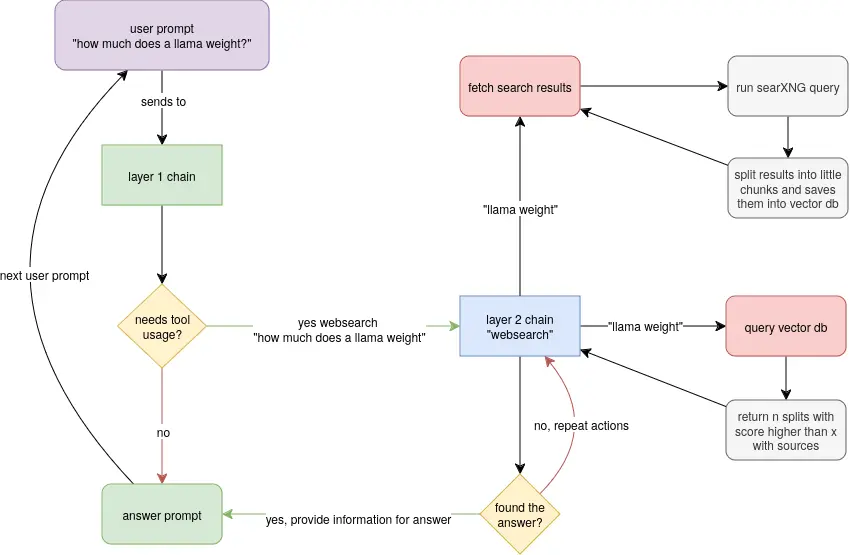

Le concept est simple mais diablement efficace. Lorsque vous lui posez une question, le système va enchaîner plusieurs modèles de langage pour trouver la réponse la plus pertinente. Tout le processus est transparent, vous pouvez suivre en temps réel la progression des agents et voir comment ils arrivent à la réponse finale, tout ça sans qu’aucune donnée ne soit envoyée sur des serveurs distants.

Mais il ne se contente pas d’être un simple moteur de recherche en local. Il propose également des fonctionnalités avancées comme la possibilité de poser des questions de suivi pour affiner votre requête initiale. Vous pouvez ainsi avoir un véritable dialogue avec le système pour obtenir exactement l’information dont vous avez besoin.

Un autre atout de LLocalSearch est sa capacité à fonctionner sur du matériel abordable. Pas besoin d’une machine de guerre avec des dizaines de gigaoctets de RAM et une carte graphique dernier cri. Le système est optimisé pour tourner sur des configurations modestes, comme le montre la vidéo de démo qui utilise un modèle de seulement 7 milliards de paramètres.

De plus, il est très simple à déployer grâce à Docker. Quelques lignes de commande suffisent pour lancer le système et commencer à l’utiliser.

git clone https://github.com/nilsherzig/LLocalSearch.git

cd ./LLocalSearch

# 🔴 vérifier les variables d'environnement dans le fichier compose (et le fichier `env-example`) et les changer si nécessaire

docker-compose up

Bien sûr, comme tout projet en phase de démarrage, LLocalSearch n’est pas exempt de bugs et de limitations. Toutes les fonctionnalités prévues ne sont pas encore implémentées et il faudra sans doute un peu de temps avant d’arriver à un système aussi complet et robuste que les moteurs de recherche en ligne que nous connaissons. Mais le potentiel est là et il ne fait aucun doute que ça va rapidement progresser grâce à une communauté open source motivée et passionnée.

En attendant, n’hésitez pas à tester cet outil et à vous faire votre propre idée.