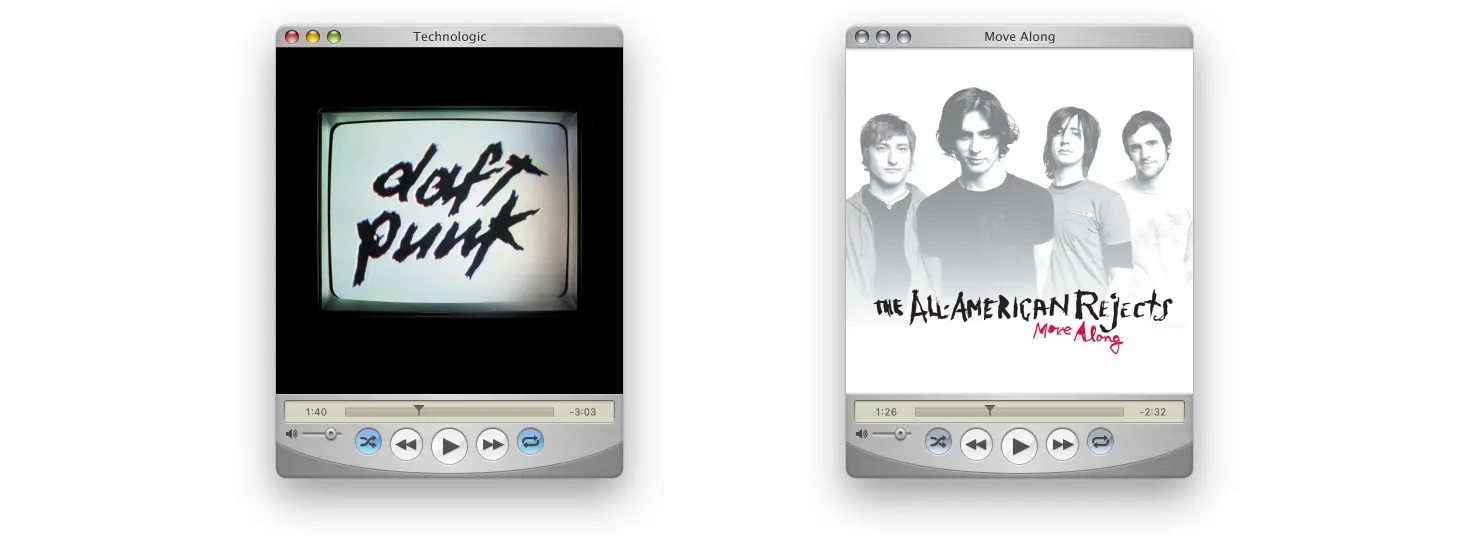

Développé à Copenhague, QuickTune est un mini lecteur pour Apple Music dispo sur macOS et qui adopte l’interface iconique de QuickTime.

Pour ceux qui n’ont pas connu cette époque (bouuuh les jeunes), sachez que QuickTime Player était autrefois le lecteur multimédia par défaut sur Mac OS X. Avant l’avènement d’iTunes, puis d’Apple Music, c’était QuickTime qui gérait nos vidéos, nos morceaux de musique et même des contenus VR. C’est d’ailleurs encore un outil présent par défaut dans macOS, même si son look n’a plus rien à voir avec ce qu’il était à l’époque.

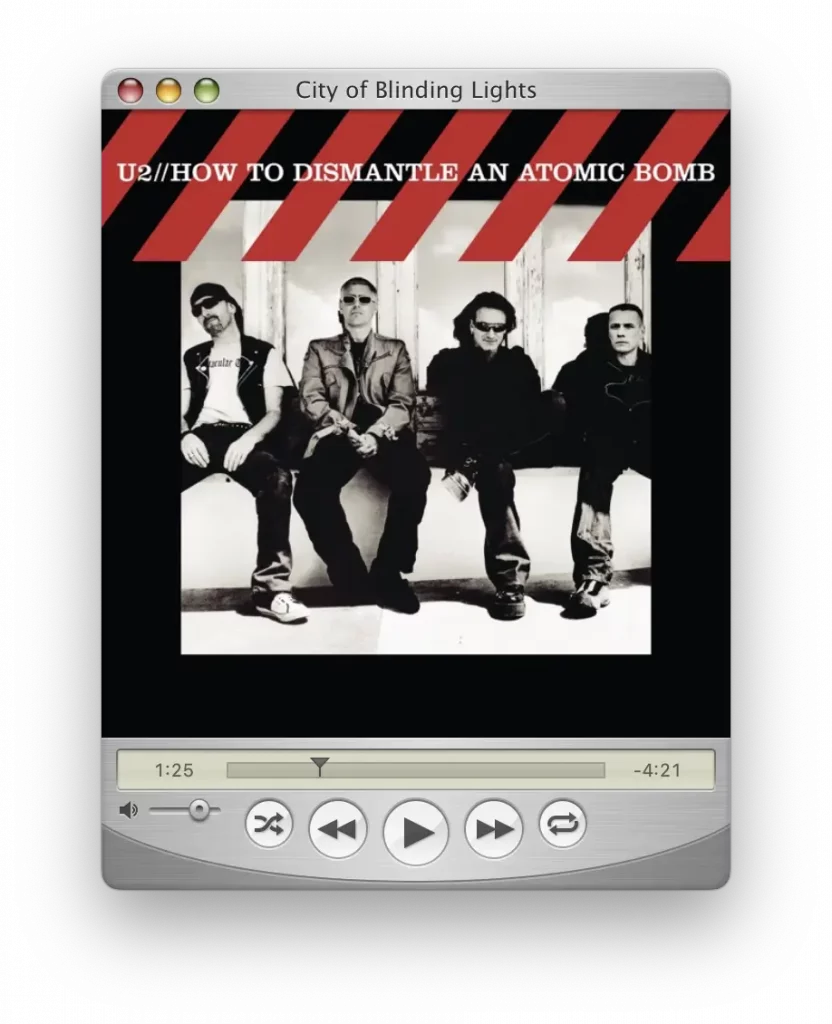

Avec QuickTune, on retrouve tout le charme de cette interface rétro, de la texture métallique brossée aux boutons vitreux, sans oublier l’affichage LCD très utilitaire. C’est un bond dans le passé en termes de design, mais au lieu de lire des fichiers locaux, QuickTune se connecte directement à votre bibliothèque Apple Music.

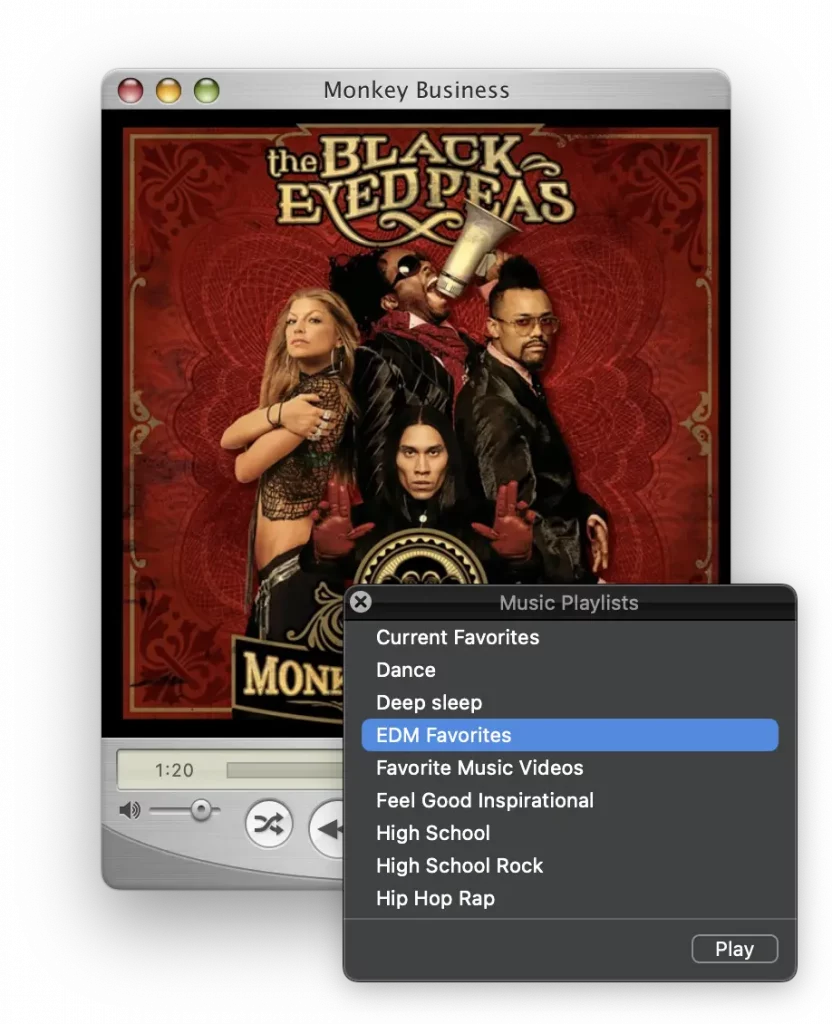

Bien que vintage en apparence, il propose des fonctionnalités plutôt bien pensées comme l’affichage de la pochette de l’album en cours de lecture, une vue détaillée, inspirée de l’inspecteur de fichiers de QuickTime, vous donne également accès à de nombreuses informations sur le morceau, telles que l’année de sortie, le genre ou les artistes. L’application permet également d’ouvrir un HUD permettant de gérer et de changer de playlists directement, sans avoir à lancer Apple Music.

Techniquement, ce logiciel est écrit en Swift + AppKit et utilise des composants natifs macOS pour se synchroniser avec Apple Music. Il est compatible à partir de macOS Big Sur et versions plus récentes, et fonctionne à la fois sur les Mac équipés de processeurs Apple Silicon et Intel. Et c’est disponible en anglais, espagnol, italien, finnois, allemand et polonais.

Perso, je trouve le concept de QuickTune irrésistible, même s’il n’est pas nécessairement indispensable au quotidien. Pour ceux d’entre vous qui ont utilisé intensivement QuickTime dans les années 90, voir cette interface ressuscitée dans une application moderne est une expérience unique, comme on l’a vécu récemment avec Winamp par exemple. Un petit plaisir coupable !

Bref, je vous invite à jeter un œil à QuickTune car c’est un bel hommage à ce lecteur culte, et également une application bien pensée pour profiter de votre musique Apple Music.