Enfin un Agent IA dans Visual Studio Code

Le fossé entre IDE traditionnel et environnement de dev piloté par IA vient de se réduire considérablement ! Si vous codez encore avec vos petits doigts comme un développeur du siècle dernier, il est maintenant temps de passer à la vitesse supérieure !!!

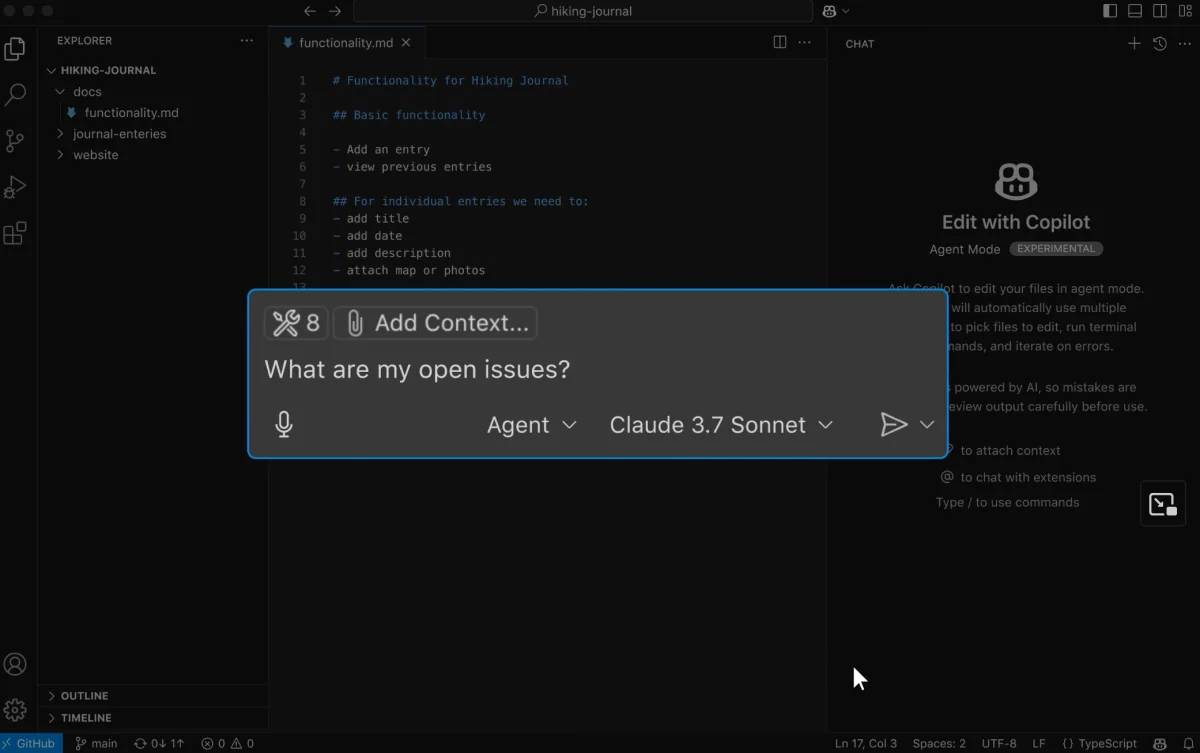

En effet, Visual Studio Code 1.99 vient de sortir et intègre maintenant un mode Agent directement dans le Chat Copilot déjà présent. Cette fonctionnalité qui permet de programmer en langage naturel via un agent IA (le fameux vibe coding… yeeeah Braïce !) est maintenant capable d’effectuer des séries d’actions complexes comme créer plusieurs fichiers, lancer des commandes, faire des recherches, lancer des tests et écrire de la doc en parallèle… Top non ?

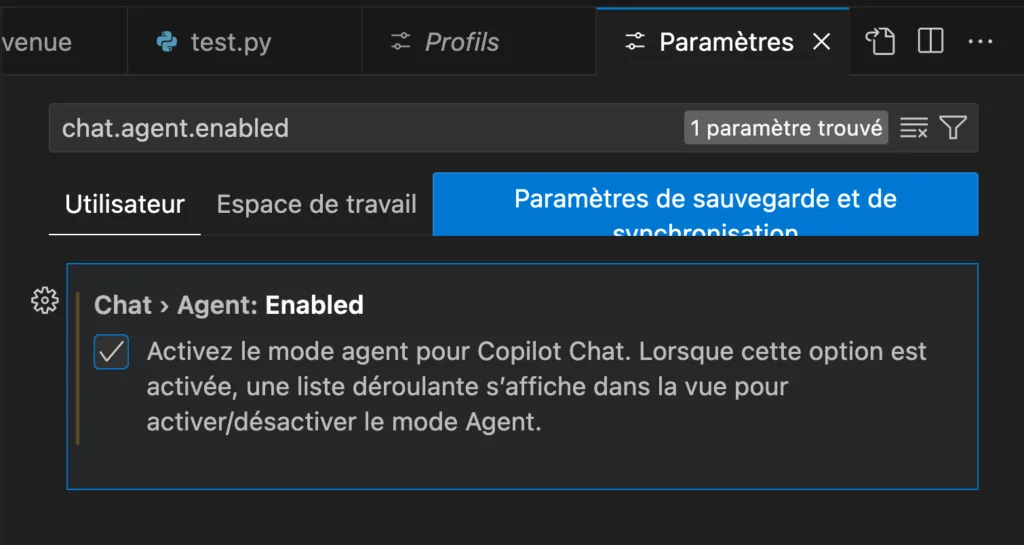

Pour activer ce mode Agent, vous devez aller dans vos paramètres, et rechercher :

chat.agent.enabled

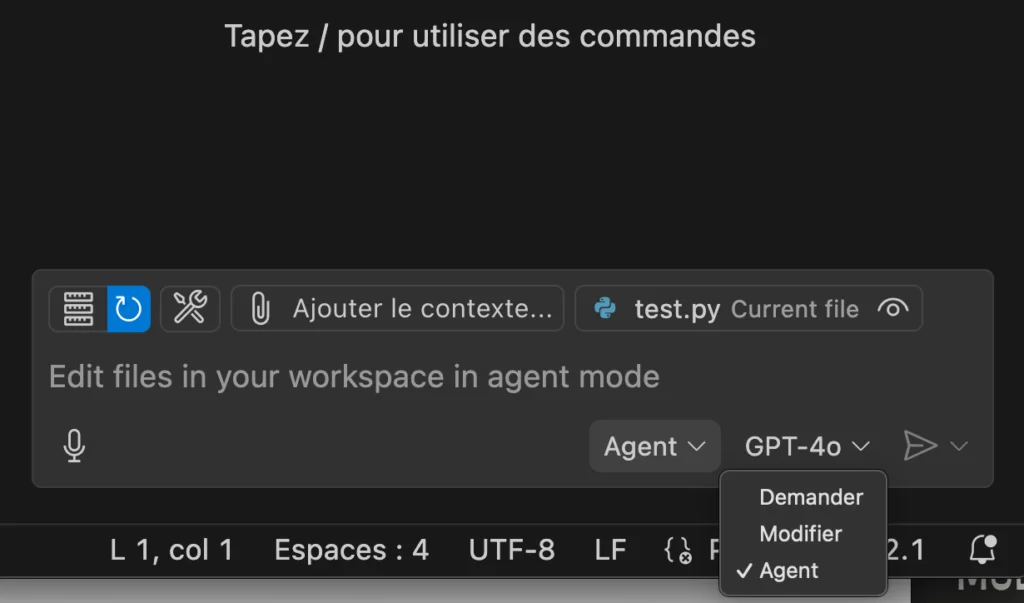

Une fois que c’est activé, rendez-vous dans la fenêtre de Chat Copilot et sélectionnez le mode Agent. Ce mode Agent utilise un outil “Thinking” qui permet à l’IA de réfléchir par étapes comme le fait par exemple Anthropic avec Sonnet 3.7 Extended Thinking.

Il intègre également d’autres outils puissants comme le Fetch tool qui vous permet de récupérer du contenu de pages web publiques directement dans vos prompts, le Usages tool qui combine “Find All References”, “Find Implementation” et “Go to Definition” pour permettre à l’IA de comprendre profondément votre codebase. Et cerise sur le gâteau, il offre aussi un support pour lancer des commandes terminal et utiliser vos extensions VS Code directement en mode Agent.

Comme ça vous allez pouvoir lui demander des trucs du genre : “Crée un endpoint API Express qui se connecte à ma base MongoDB, avec validation et gestion d’erreurs”… et regarder l’Agent créer tous les fichiers nécessaires, installer les dépendances, et même écrire les tests unitaires.

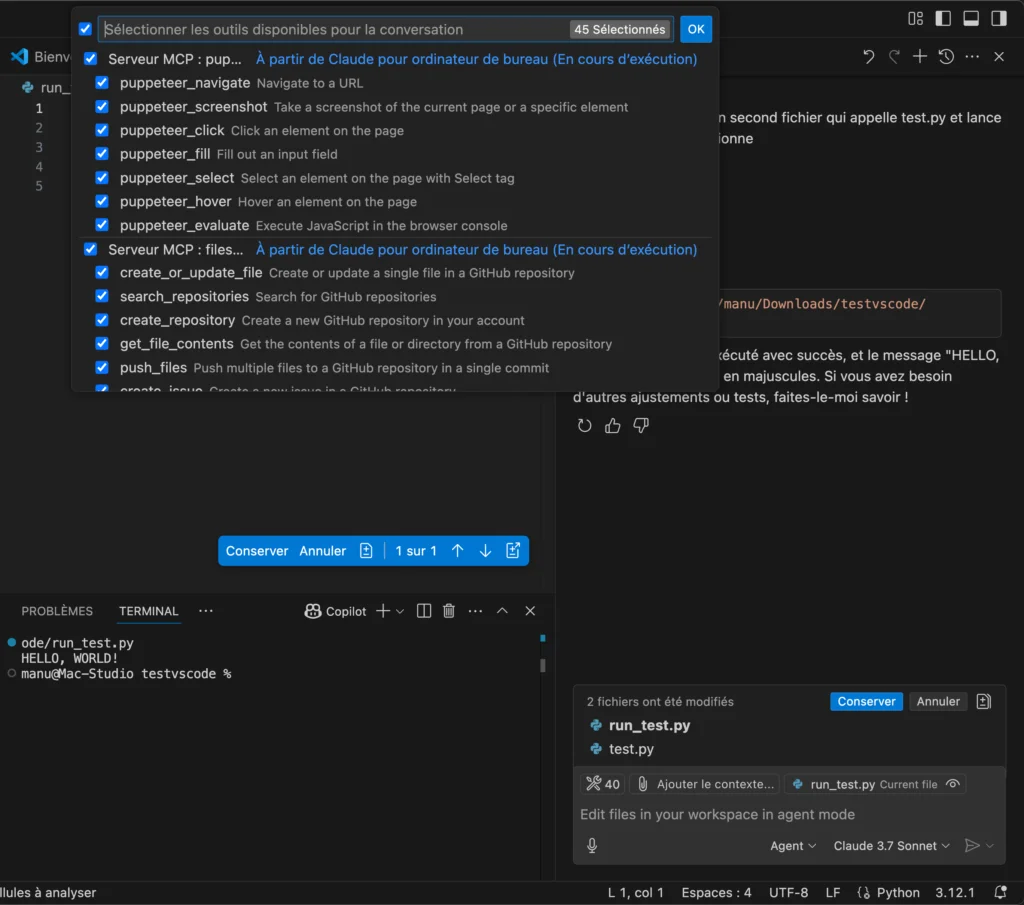

Autre nouveauté majeure, le protocole MCP (Model Context Protocol) est désormais supporté. Ça va vous permettre de faire interagir votre modèle IA avec des outils externes, applications et sources de données de manière standardisée.

Mais ce n’est pas tout ! VS Code introduit également le support d’API personnalisées pour Copilot Pro et Free. Concrètement, ça signifie que vous pouvez maintenant utiliser :

- Azure OpenAI

- Anthropic (Claude)

- Google Gemini

- OpenAI (Différents modèles GPT)

- Ollama (pour vos modèles locaux - idéal pour bosser hors ligne)

- Open Router (pour accéder à un catalogue étendu de modèles)

Comme ça, si vous êtes parano sur la confidentialité de votre code, y’a plus qu’à faire tourner Ollama en local, et votre code ne quittera jamais votre machine. Et si votre boîte a investi dans des services Azure, vous pouvez les utiliser directement via votre abonnement sans passer par l’offre standard de Microsoft.

Et si comme moi, vous êtes fan de Claude, vous pouvez maintenant connecter l’API d’Anthropic et profiter de ses capacités de compréhension de code bien meilleures que GPT-4o.

VS Code 1.99 ne s’arrête pas uniquement à ce nouveau mode Agent. En effet, Microsoft a amélioré l’expérience IA sur tous les fronts :

- Vue chat unifiée : basculez facilement entre les modes Ask, Edit et Agent

- Support d’images : glissez-déposez des images dans le chat (formats .jpg, .png, .gif, .webp, .bmp)

- Next Edit Suggestions (NES) maintenant en version finale

- Indexation instantanée de votre codebase pour répondre aux questions via #codebase/@workspace

- Recherche sémantique par IA activée par défaut dans la vue Search

- Support d’édition IA pour les notebooks Jupyter

La recherche sémantique est particulièrement bluffante car au lieu de galérer avec des regex alambiquées, vous pouvez simplement taper “trouve toutes les fonctions qui manipulent des données utilisateur sans validation” et l’IA comprend ce que vous cherchez. Magique.

Voilà donc si vous hésitiez entre Windsurf ou Cursor pour un IDE boosté à l’IA, et bien, restez sur VS Code, c’est peut-être encore ce qu’il y a de plus simple ! Surtout que vous pouvez le faire tourner avec vos propres modèles locaux ou via API si vous le souhaitez.