Souvenez-vous, il y a quelque temps, je vous avais parlé de la fantastique petite console Pico-8. Eh bien, les créateurs de ce petit bijou sont de retour avec un nouveau projet tout aussi excitant : Picotron !

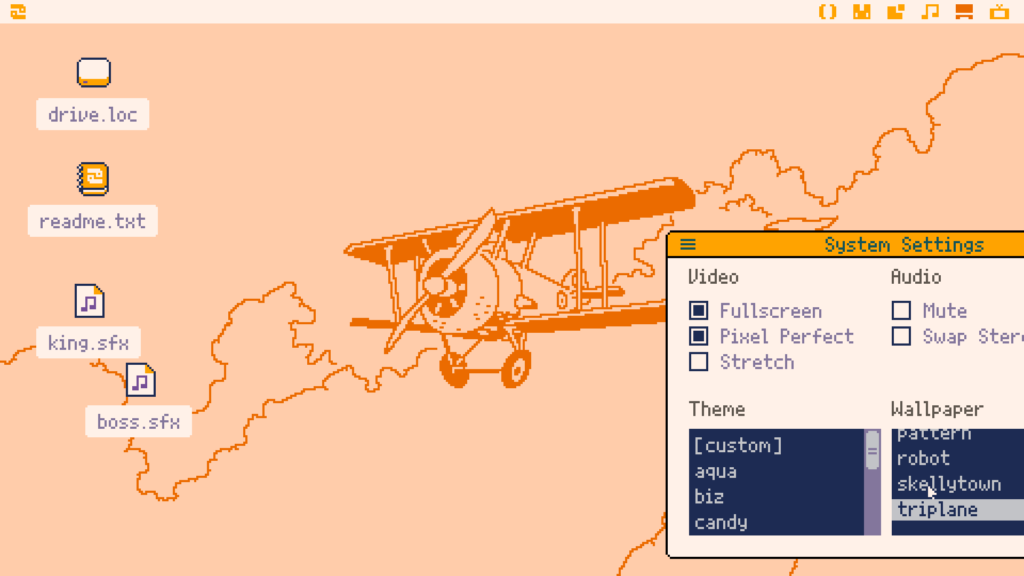

Il s’agit d’une station de travail 8-bit (workstation), c’est à dire un environnement de développement complet permettant de créer des jeux et des outils très cools. Tout comme Pico-8, Picotron repose sur le concept d’une machine imaginaire dotée d’outils intégrés mais attention, cela va encore plus loin que Pico-8 en termes de flexibilité et de puissance.

Déjà, côté specs, on a droit à un affichage plus grand (480×270 pixels contre 128×128 pour Pico-8) et une capacité de stockage des cartouches étendue à 256Ko. Mais la vraie force de Picotron, c’est son approche des outils intégrés. Contrairement à Pico-8, tous les outils de création de Picotron sont écrits en Lua et peuvent être modifiés directement dans la machine. Même des éléments comme l’explorateur de fichiers ou l’éditeur de code font partie de l’espace utilisateur.

Comme ça, vous pouvez créer vos propres logiciels from scratch, et ils tourneront en plein écran au même titre que les outils fournis. C’est cette orientation vers la personnalisation et l’extension qui vaut à Picotron le titre de « Workstation » plutôt que de simple « Console ». Cela dit, les aficionados de Pico-8 ne seront pas dépaysés puisque Picotron supporte la même syntaxe et une bonne partie de ses API. Moyennant quelques ajustements (Picotron utilise des nombres à virgule flottante là où Pico-8 se contente de nombres entiers), il est assez facile de porter les cartouches Pico-8 vers ce nouvel environnement.

Et ce n’est pas qu’un simple Pico-8 Plus puisque la machine apporte également son lot de fonctionnalités, à commencer par son moteur graphique avec 64 couleurs affichables simultanément, entièrement paramétrables via des valeurs RGB. On peut même basculer entre 4 palettes de 64 couleurs à la volée, et ce à chaque ligne de balayage ! De quoi faire des effets de ouf.

Il intègre aussi un « moteur » sonore maison baptisé PFX6416 qui vous permettra de produire des sons riches et variés tout en restant concis en terme de données. Les instruments sont définis via des arbres de « nœuds » qui génèrent ou modifient un signal, le tout séquencé à la façon d’un tracker. Un seul instrument peut ainsi mobiliser jusqu’à 64 nœuds répartis sur 16 canaux !

Évidemment, on retrouve dans Picotron le workflow typique des consoles fantaisies. Un fichier de cartouche unique (*.p64) qui encapsule le code, les graphismes, les sons, etc. Et ces fichiers peuvent aussi également manipulés comme des dossiers depuis l’OS de la machine. C’est pratique pour copier des ressources directement d’une cartouche à l’autre.

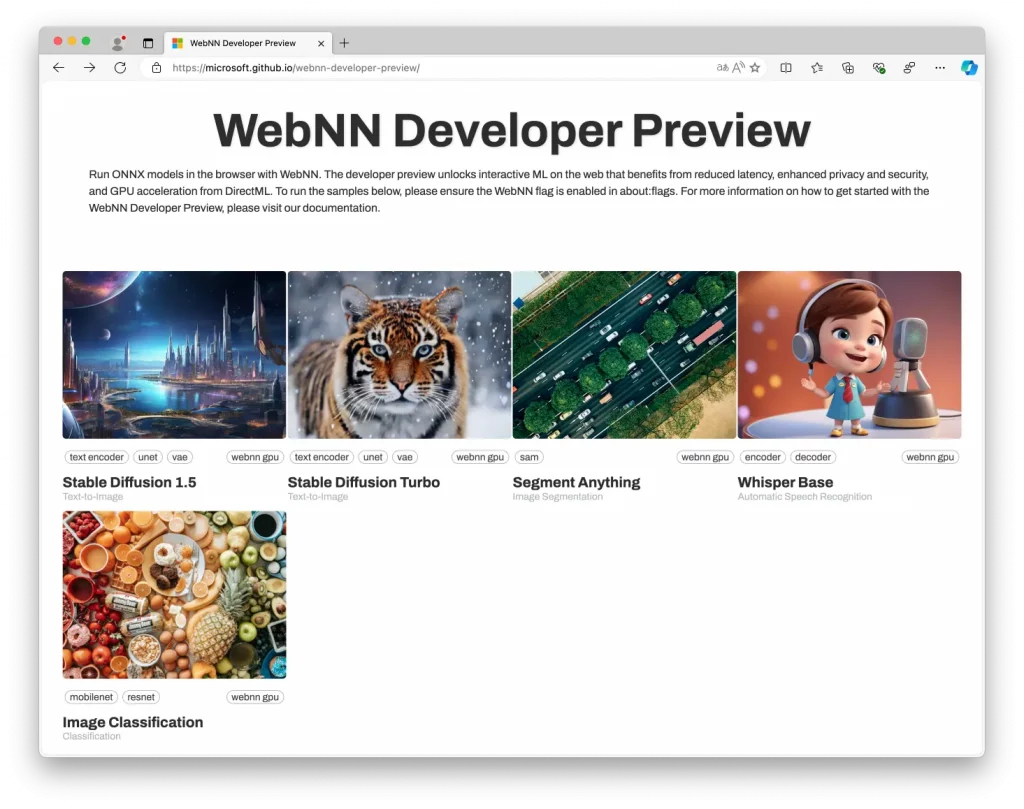

Niveau performances, Picotron se veut à la fois plus véloce que Pico-8 (environ 2x plus rapide en instructions Lua pure) et suffisamment efficient pour tourner sur des configs modestes, y compris dans un navigateur web. Des primitives comme le rendu de triangles texturés permettent de réaliser des prouesses techniques sans sacrifier la fluidité.

C’est dispo sous Windows, Mac, Linux ainsi qu’en HTML5 alors vous n’avez aucune excuse pour ne pas essayer.

En effet, Picotron incarne, selon moi, le fantasme parfait du geek : un ordi 8-bit idéal et hyper versatile, qui carbure à l’imagination de ses utilisateurs et dont le code est totalement ouvert et hackable. Bref, j’ai hâte de voir l’écosystème qui va se développer autour de ce truc : Outils dédiés, démos techniques, jeux old school ou petites pépites… les possibilités offertes par Picotron semblent infinies.