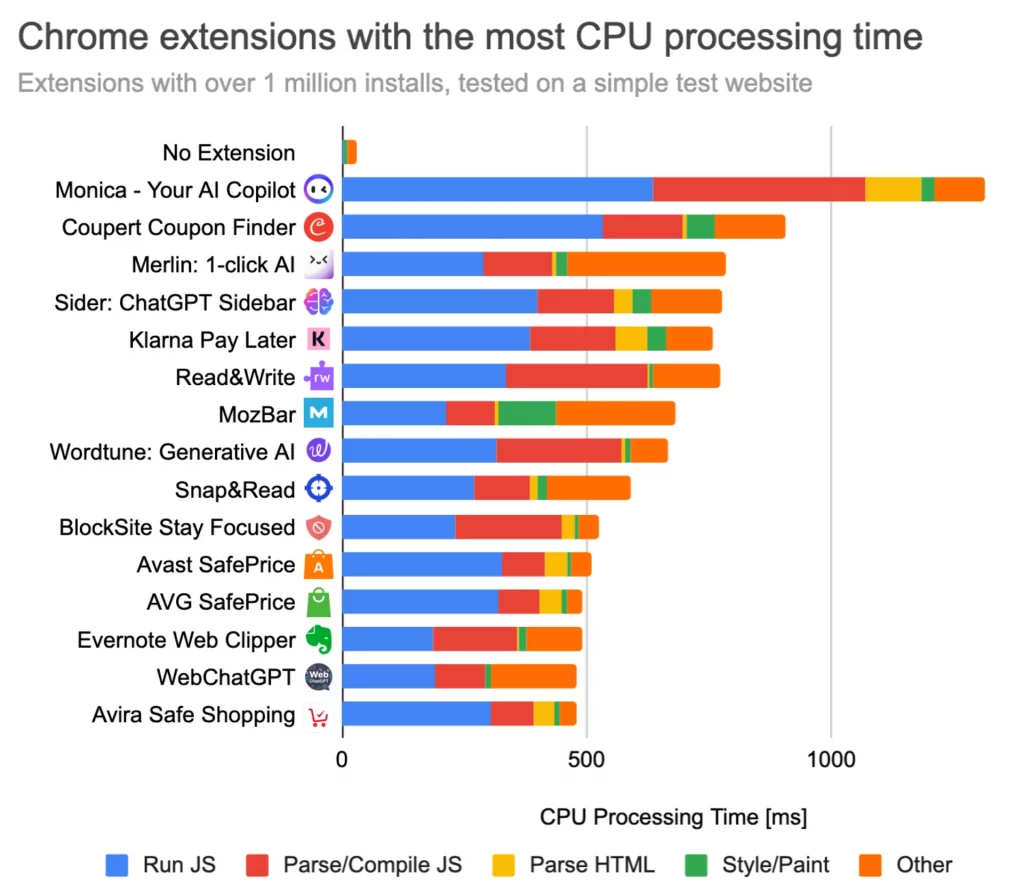

On s’en doutait, mais là c’est prouvé scientifiquement : Les extensions Chrome peuvent sérieusement ralentir vos séances de surf !

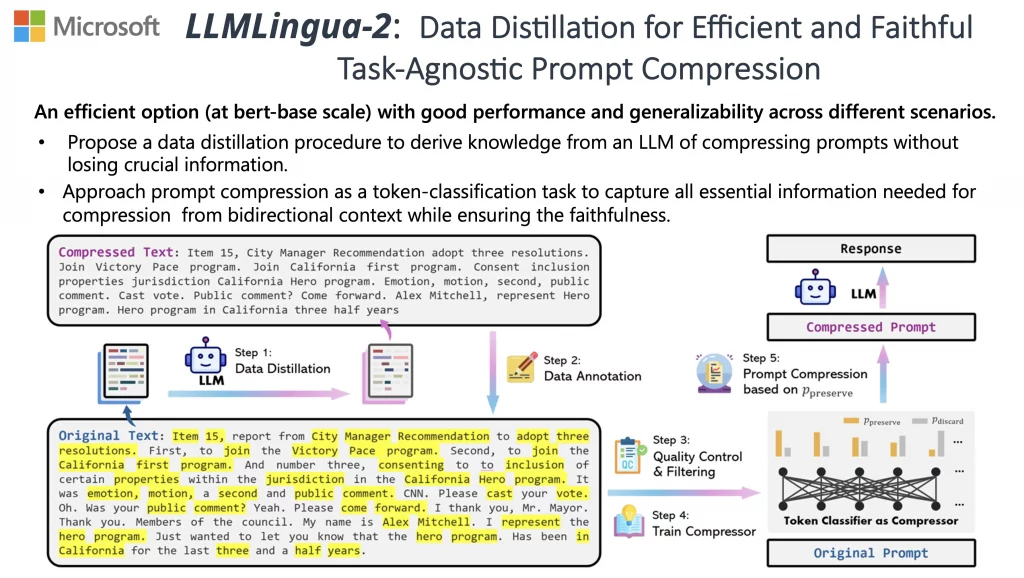

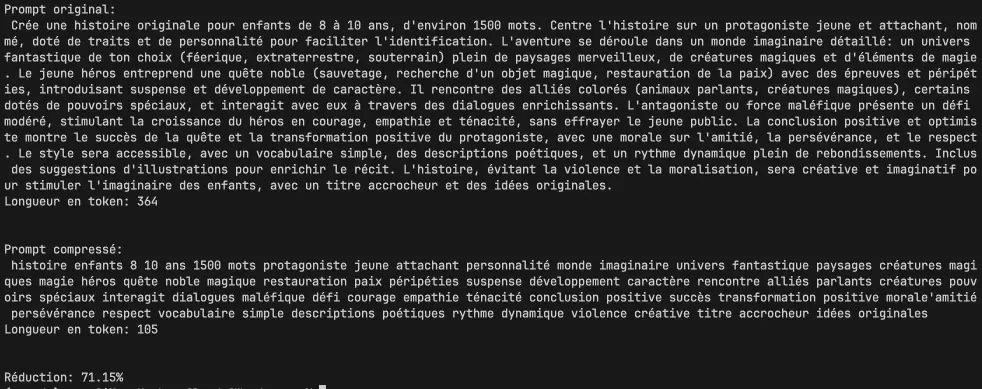

C’est en tout cas ce que révèlent les tests menés par la bande de geeks de DebugBear qui ont passé au crible les 5000 extensions Chrome les plus populaires pour voir l’impact sur les performances. Et c’est décevant… Prenez par exemple Monica, un outil IA avec ses 2 millions d’utilisateurs. Et bien elle rajoute tranquillement 1,3 seconde de temps de traitement sur chaque page, même les plus basiques ! Pas glop…

Un autre exemple concerne Honey, un outil qui propose des coupons de réduction et qui compte 20 millions d’utilisateurs. Quand vous surfez sur un site de shopping comme Ikea, ce petit malin s’active et vous colle 1,5 seconde de CPU en plus. Bonjour l’addition !

Mais le pire du pire, c’est MaxAI et ses 800 000 utilisateurs. Cet outil infernal ajoute carrément 2,3 secondes de traitement à chaque page ! What the heck ? On n’est pas tous équipés d’un super GPU quantique de la mort pour compenser le laxisme des dev…

Notons aussi que « Superagent – Automatic cookie consent » cause plus de 4 secondes de traitement par page. Certains programmes de récompenses pour les compagnies aériennes présentent un impact similaire, ajoutant encore plus de délai lorsqu’ils sont actifs.

Heureusement, la plupart des extensions ne sont pas si terribles. 86% ont un impact négligeable, avec moins de 50 millisecondes de temps CPU supplémentaire. Ouf ! Par contre, il y en a quand même 1,7% qui dépassent allègrement la demi-seconde et ça c’est pas cool.

En creusant un peu, on voit que pas mal d’extensions VPN ou de gestionnaires de mots de passe ralentissent sévèrement le chargement des pages. Forcément, elles font transiter les données par des serveurs souvent lents à l’autre bout du monde, donc ça aide pas…

Mais il y a quand même une bonne nouvelle dans ce merdier ! Les bloqueurs de pubs, eux, accélèrent carrément la navigation. Normal, ils empêchent le chargement de tout un tas de contenus indésirables. uBlock Origin, l’un des plus populaires avec ses 37 millions d’utilisateurs, fait fondre le temps de traitement de 57 secondes à moins de 4 secondes sur les sites pleins de pubs ! Magique, mais pensez quand même à le débloquer sur mon site pour me soutenir ou à rejoindre mon Patreon si un jour l’un de mes articles vous a aidé et que vous appréciez mon boulot !

Et au niveau des données téléchargées, ça change la vie. Sans bloqueur, un site bourré de pubs pèse 41 Mo. Avec uBlock Origin, on tombe à moins de 3 Mo. Impressionnant ! Bon après, AdBlock et AdBlock Plus, je vous les déconseille car ils sont moins efficaces. Peut-être à cause du programme des « publicités acceptables » qui peut être désactivée pour améliorer les performances ? Va savoir…

Bref, avis aux développeurs d’extensions : optimisez votre code s’il vous plait ! Chargez le strict minimum, faites tourner vos scripts après le chargement de la page, pas avant. Et laissez les gens tranquilles, n’activez pas vos outils sur tous les sites par défaut quand ça n’a pas lieu d’être !

Google devrait aussi mettre un peu la pression et promouvoir les extensions légères et bien foutues car les gros scripts bien lourds qui se lancent de partout, ça va bien 5 minutes !

Bref, c’est le printemps (même s’il pleut tout le temps), alors profitez en pour faire le tri dans vos extensions ! Virez celles qui ne vous servent à rien et qui bouffent de la ressource comme pas permis ou à minima, désactivez-les quand vous n’en avez pas besoin. Votre navigateur vous dira merci !